计算机视觉深度度量学习:简要概述

摘要

摘要

优化深度神经网络的抽象目标函数在创建输入数据的增强特征表示方面起着至关重要的作用。尽管基于交叉熵的损失公式已广泛用于各种有监督的深度学习应用,但当输入数据分布中存在较大的类内方差和低类间方差时,这些方法往往不太合适。深度度量学习旨在通过学习将这些数据样本映射到代表性嵌入空间的表示函数来开发旨在测量数据样本之间相似性的方法。它利用精心设计的采样策略和损失函数来帮助优化判别嵌入空间的生成,即使对于类间方差低、类内方差高的分布。在本章中,我们将概述该领域的最新进展并讨论最先进的深度度量学习方法。

介绍

度量学习领域目前是一个活跃的研究领域。传统上,度量学习已被用作创建最佳距离度量的方法,该度量考虑了数据点的特定属性和分布(例如马氏距离)。随后,这些方法演变重点是从针对给定特定距离度量(例如欧几里得距离或余弦距离)优化的数据创建表示。随着深度学习的出现,这些特征表示已经使用复杂的非线性变换端到端学习。这导致深度度量学习 (DML) 领域的主要研究专注于创建用于训练深度神经网络的损失/目标函数。广泛使用的深度度量学习方法的一个关键领域之一是计算机视觉。这是因为大多数计算机视觉应用处理场景属于同一类的数据样本的视觉特征存在很大差异。此外,属于不同类别的多个样本可能在视觉特征上有许多相似之处。

卷积神经网络 (CNN) 的最新进展有助于从图像中创建良好的特征表示。虽然在监督学习设置下使用 CNN 作为特征提取器,但通常使用基于 Softmax 的目标函数。尽管这些损失公式在许多应用中往往很有效,但在对具有高类间和低类内方差的输入数据进行建模时,它们往往会受到影响。数据的这些属性存在于人脸识别[7]、指纹识别[14][16]、图像检索[10]、人员再识别[17]和跨模态检索[12]、[19]等各种实际应用中。在这种情况下,基于深度度量学习的损失公式用于创建高度可区分的嵌入空间。这些嵌入空间的设计目的是对属于同一类的样本的特征表示进行聚类,并与流形中其他类的聚类很好地分离。

在本章中,我们将讨论作为文献一部分的流行深度度量学习公式。我们将将我们的讨论限制在在不同计算机视觉任务中发现应用程序的方法上。我们根据总体目标公式的类型将不同的损失公式分为三类,如图1所示。第一类由基于对的公式组成,该公式基于数据集中样本之间的直接基于对的交互来制定总体目标。第二种是一组使用伪类代表作为代理来制定最终优化的方法。最后,我们还讨论了尝试合并辅助信息的正则化方法,以帮助创建更优化的特征表示。

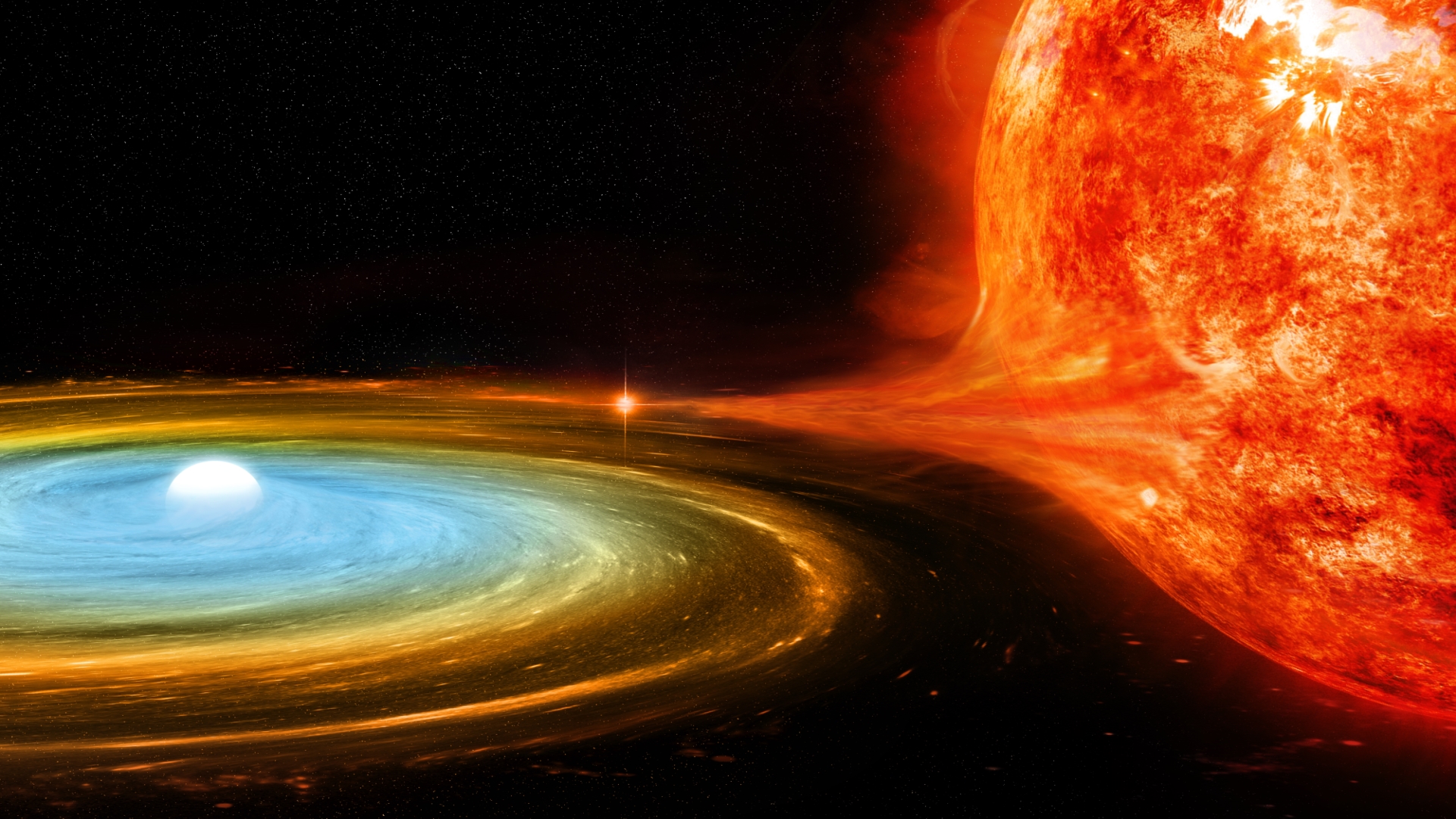

图 1:描述各种类型的深度度量学习损失的图示。

图 1:描述各种类型的深度度量学习损失的图示。

Pair-based 方法

1、Contrastive Loss

2、Triplet Loss

3、N-Pair Loss

4、Multi-Similarity Loss

4、Multi-Similarity Loss

Proxy-Based 方法

Proxy-Based 方法

基于代理的方法已经被提出来克服传统基于对的方法的信息对挖掘瓶颈。特别是,这些基于代理的方法利用一组可学习的共享嵌入,在训练期间充当类代表。训练集中的每个数据点都近似于至少一个代理。与基于对的方法不同,这些类代表代理不会因每个批次而变化,并且在样本之间共享。由于这些代理从每批中的所有样本中学习,因此它们消除了显式挖掘信息对的需要。

1、ProxyNCA

2、ProxyNCA++

3、Proxy Anchor Loss

4、ProxyGML Loss

正则化

在前面的部分中,我们探索了基于对和基于代理的损失公式来创建增强的特征表示。这些方法中的大多数都专注于基于样本-样本交互或样本-代理交互创建新的公式。还有其他任何可以利用的信息来创建更强大的嵌入空间。在本节中,我们将查看两种此类信息来源、语言和方向,并查看如何将这些集成到现有的深度度量学习公式中。

语言指导

利用大型语言模型表示中的语义上下文来提高深度度量学习目标,将语言模态的知识合并到视觉模态中。相当于用Bert模型获取语言向量,并与视觉的特征进行KL散度计算。

方向正则化

到目前为止介绍的深度度量学习方法利用精心设计的采样策略和损失公式来帮助优化可辨别嵌入空间的生成。虽然已经做了很多工作来改进采样和损失公式的过程,但对对之间的相对相互作用以及施加在这些对上的力(引导它们在嵌入空间中的位移)的关注相对较少。为了理解最佳位移的必要性,我们重新审视三重态损失和力作用的方向。人们可以注意到,在一次更新期间,负样本被径向地推离锚点。尽管直观上将负样本径向远离锚点是有意义的,但由于该方向上存在其他正样本,这可能是次优方向。还需要注意的是,三元组中的正样本不会影响作用在负样本上的力的方向。那么,是否存在更优化的力量作用方向呢?

最小化这个余弦相似项有助于满足方程中的条件。由于当前的度量学习损失缺乏对负样本相对于锚定正对的正交性的明确执行,因此当将其合并为正则化项时,它有助于创建更强大的嵌入空间。以下方程提供了定义和直觉,说明该正则化项可以如何轻松地适应任何标准度量学习损失函数。

修改后的Multi-similarity loss可以写成:

评论区