从神经激活到概念:神经网络解释概念综述

摘要

摘要

在本文中,我们回顾了最近解释神经网络概念的方法。概念可以作为学习和推理之间的自然联系:一旦确定了神经网络系统使用的概念,就可以将这些概念与推理系统集成进行推理,或者使用推理系统对其进行改进或增强学习系统。另一方面,知识不仅可以从神经网络中提取,还可以将概念知识插入到神经网络架构中。由于整合学习和推理是神经符号 AI 的核心,因此从这项调查中获得的见解可以作为基于可解释概念实现神经符号 AI 的重要一步。

介绍

近年来,神经网络在被认为需要人类水平的智能的任务取得了成功,例如理解和生成图像和文本、执行对话和控制机器人遵循指令[1 - 3]。然而,他们的决策往往无法解释,这破坏了用户的信任,并对它们在敏感或关键领域(如自动化、法律和医学)中的使用产生负面影响。克服这一限制的一种方法是使神经网络可解释,例如,通过设计它们来生成解释或使用事后解释方法来分析神经网络在训练后的行为。本文回顾了可解释的人工智能 (XAI) 方法,重点是解释神经网络如何学习概念,因为概念可以作为构建复杂规则的原语,将自己呈现为学习和推理之间的自然链接 [4],这是神经符号 AI 的核心 [5-9]。一方面,识别神经网络对给定输入使用的概念可以为用户提供有关网络用于生成其输出的信息 [10, 15]。结合提取所有相关概念及其(因果)关系的方法,可以在逻辑或自然语言中生成解释,忠实地反映网络决策过程。另一方面,已识别的概念可以帮助符号推理器干预神经网络,以便通过修改概念来实现调试网络[11,16 -18]。近年来发表了一些XAI调查[19 -25]。然而,它们中的大多数主要关注使用显着性图来突出重要的输入特征。只有少数调查包括概念解释作为解释神经网络的一种方式。最近在这方面的调查是由Casper等人[26]提出的,它讨论了广泛的解释神经网络内部的方法范围。然而,由于其更广泛的范围,调查没有提供解释概念的方法的详细描述,并错过了该领域的最新进展。另一方面,Schwalbe [27] 和 Sajjad 等人的调查致力于特定类型的概念解释方法,重点是视觉 [27] 或自然语言处理 [28],因此范围有限,无法一起分析这两个领域。我们对概念解释方法进行分类,并根据它们是否在单个神经元级别(第 2 节)或层级别解释概念来构建这项调查(第 3 节)。最后一部分用悬而未决的问题总结了这项调查。

神经元级解释

可以表示概念的神经网络中最小的实体是一个神经元[28],它可以在更广泛的意义上——也是卷积神经网络[10]中的单元或过滤器。在本节中,我们调查了以事后方式解释预训练神经网络神经元所代表的概念,无论是通过比较概念与神经元激活之间的相似性(参见第 2.1 节),还是通过检测概念与神经元激活之间的因果关系(参见第 2.2 节)。

使用概念和激活之间的相似性

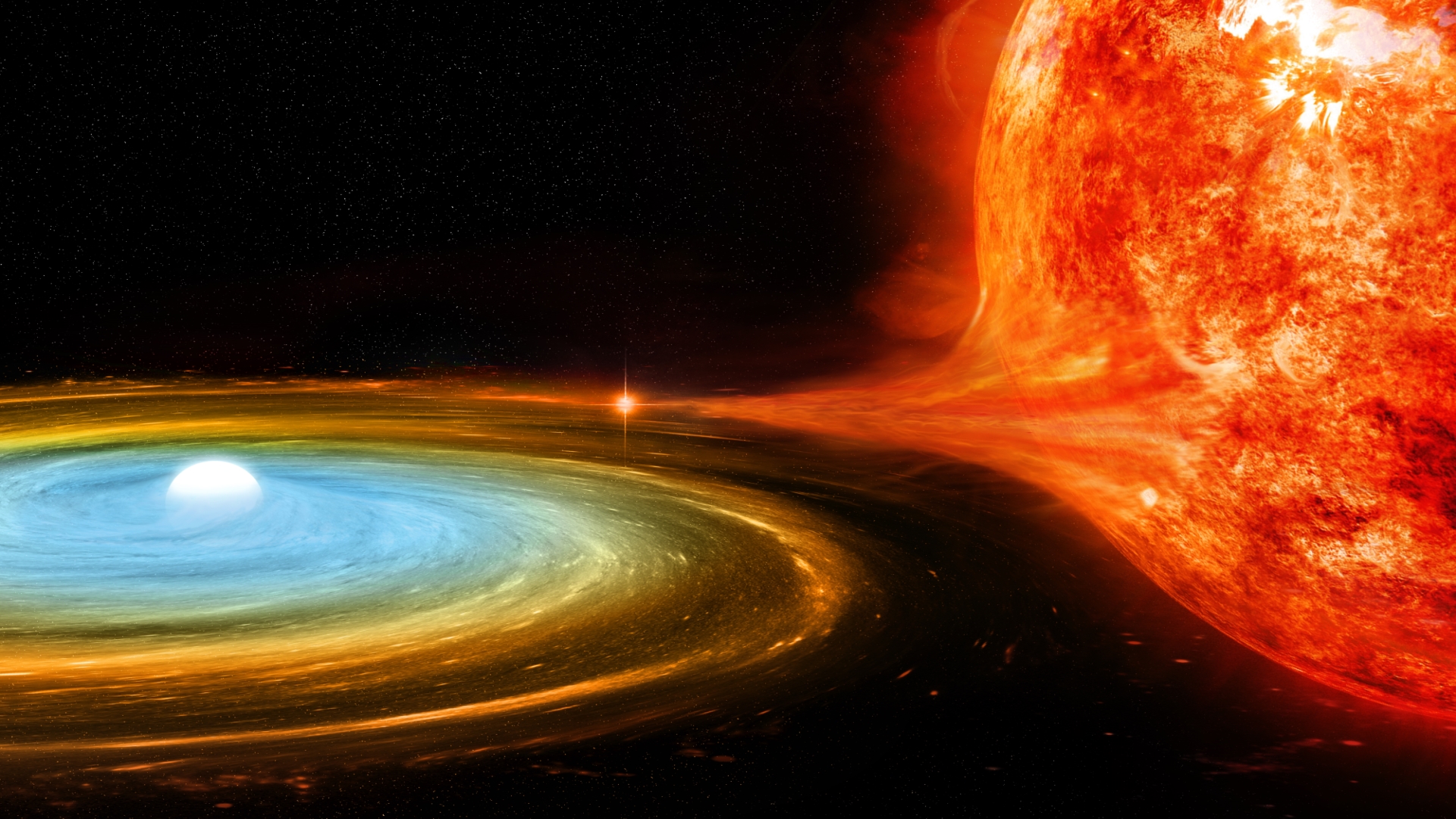

图 1. 使用概念和激活之间的相似性的神经元级解释。描述是网络解剖方法,它将输入中的分割概念与神经元[10]的激活掩码进行比较。

图 1. 使用概念和激活之间的相似性的神经元级解释。描述是网络解剖方法,它将输入中的分割概念与神经元[10]的激活掩码进行比较。

使用概念和激活之间的因果关系

图 2. 使用概念和激活之间的因果关系的神经元级解释。在因果中介分析中,如果对输入有干预(输入句子中的主语从单数变为复数),神经元的激活被修改为神经元将输出的激活。之后,它测量了有和没有干预的动词正确共轭的预测之间的变化量 [38]。

图 2. 使用概念和激活之间的因果关系的神经元级解释。在因果中介分析中,如果对输入有干预(输入句子中的主语从单数变为复数),神经元的激活被修改为神经元将输出的激活。之后,它测量了有和没有干预的动词正确共轭的预测之间的变化量 [38]。

层级解释

概念也可以由整个层表示,而不是神经元或卷积滤波器,如第 2.1 节中关于 Fong 等人的工作的段落中提到的。这可以通过将概念数据集 C 的示例传递给模型并提取特定层的激活来训练概念分类器来事后实现预训练模型。在层级解释中,两种方法突出:第一个是用概念激活向量 (CAV) 解释(参见第 3.1 节),第二个是探测(参见第 3.2 节)。这两种方法的主要区别在于,在 CAV 的情况下,为每个概念 C ∈ C 训练一个线性二元分类器,并且在探测多类分类器时,使用通常与某些语言特征相关的分类标签进行训练(例如,情绪、词性标签)。另一方面,概念可以烘焙在一个层中,其中每个概念代表一个神经元,就像神经网络研究早期使用本地主义表示所做的那样(参见第 3.3 节)。

使用向量来解释概念:概念激活向量

图3。使用向量解释概念的层级解释。对于每个概念 C 正例 x+C 和负例 x-C 被馈送到预训练模型,以从目标层的相应激活中学习所谓的概念激活向量 (CAV) vC [12]。

使用分类器来解释概念:探测

图4。使用分类器解释概念的层级解释。在此示例中,预训练模型将句子作为输入,并将探测分类器应用于突出显示层的激活,以检查激活是否编码句子长度的概念 [46]。

使用本地表示:概念瓶颈模型

图5。使用概念瓶颈模型方法[11]的层级解释。概念瓶颈 f ℓ 中的每个神经元都对应于一个唯一的概念(例如,翅膀颜色)。

图5。使用概念瓶颈模型方法[11]的层级解释。概念瓶颈 f ℓ 中的每个神经元都对应于一个唯一的概念(例如,翅膀颜色)。

评论区